Охотники за инопланетянами обращаются к технологии искусственного интеллекта, получившей название «Святой Грааль», обещающей «точность 90%»

На нашем сайте вы можете: подробнее узнать, что скрывается под аббревиатурой НЛО; посмотреть фото- и видеосвидетельства самых необычных явлений, которые зафиксированы на нашей планете и за пределами Земли. опубликовать свои истории, связанные с НЛО в рубрике «Глазами очевидцев» пройти тест и узнать, что вы знаете об этом феномене НЛО; узнать, кто из знаменитостей видел НЛО, и что они об этом думают; ознакомиться с подборкой захватывающих фильмов и книг про НЛО; изучить вместе с вашими детьми рубрику «всё об НЛО для самых маленьких». P.S. Вы когда-нибудь видели что-то похожее на НЛО? Или считаете, что все представленные материалы — это лишь неудачно снятые опознанные летающие объекты, а свидетельские показания — предмет разыгравшегося воображения впечатлительных людей? Поделитесь с нами вашим мнением!

Охотники за инопланетянами обращаются к технологии искусственного интеллекта, получившей название «Святой Грааль», обещающей «точность 90%»

Репортер НЛО. Часть 1: Файлы Джорджа Кнаппа | НовостиNation Prime

Репортер НЛО. Часть 1: Файлы Джорджа Кнаппа | НовостиNation Prime

«Информатор об НЛО Дэйв Груш рассказал мне все»

«Информатор об НЛО Дэйв Груш рассказал мне все»

Еще больше ДОКАЗАТЕЛЬСТВ существования инопланетян, все еще не опровергнутых – никогда не забудете

Еще больше ДОКАЗАТЕЛЬСТВ существования инопланетян, все еще не опровергнутых – никогда не забудете

Сотни призраков собираются в Дорчестере для жуткой попытки установить мировой рекорд

Сотни призраков собираются в Дорчестере для жуткой попытки установить мировой рекорд

Феномен похищения инопланетянами, обсуждаемый доктором Джоном Э. Маком и Баддом Хопкинсом (1997).

Феномен похищения инопланетянами, обсуждаемый доктором Джоном Э. Маком и Баддом Хопкинсом (1997).

Чего ждать? Стэнфордский профессор Гэри Нолан засекретил материалы НЛО

Чего ждать? Стэнфордский профессор Гэри Нолан засекретил материалы НЛО

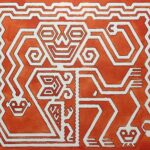

Моя реставрация украденного текстиля Паракас!

Моя реставрация украденного текстиля Паракас!

Каждый Пайпс замечен в «Дозоре призраков»

Каждый Пайпс замечен в «Дозоре призраков»

Я подумал, что некоторым из вас, уважаемые люди, может понравиться эта картина, которую я только что закончил.

Я подумал, что некоторым из вас, уважаемые люди, может понравиться эта картина, которую я только что закончил.

Теория: «В основном или все» Cointelpro

Теория: «В основном или все» Cointelpro

Okay, their paper isn’t public [https://www.pnas.org/doi/10.1073/pnas.2307149120](https://www.pnas.org/doi/10.1073/pnas.2307149120)

But their code is [https://github.com/ghystad/Machine_learning_and_preprocessing_pyr_GSMS_data/tree/master](https://github.com/ghystad/Machine_learning_and_preprocessing_pyr_GSMS_data/tree/master)

Unfortunately, my days of doing R have certainly come to a middle, I can’t find how they’re partitioning their data for the training by just quickly scanning through the code.

The main thing I wanted to find was the metric they use to determine the quality of their classifier. According to the abstract of the paper (that’s basically just quoted in the article), they’re achieving 90% accuracy with their machine. Great. That number doesn’t mean much without knowing more about the data. Classifiers using accuracy as a metric are very vulnerable to a thing called «class imbalance» — simple example:

Imagine you want to make the good old «cat vs dog» classifier and make a machine that can tell whether the animal in your picture is a cat or a dog. You use accuracy as your success metric, which means you check how many times your classifier gives the right answer. If you have 100 images to train it on, and they show 50 dogs and 50 cats, fantastic.

But if you have 100 images, and 90 show dogs and 10 show cats, the fastest and most effective «algorithm» is to just say dog *every time*. No check, no nothing. And you’d be 90% accurate.

On the face of it, accuracy sounds like a reasonable metric, but it isn’t always, and they’re not telling us the details of the dataset, and there’s no obvious check for this in the training code either, at least not one that I saw. And you’d be surprised how many people go for the «let’s just use AI!» approach and overlook these details when training.

Let’s wait and see, but without the paper being in the public domain, it’s hard to trust the results of this «holy grail».

Bitch I’ve been doing this for like a year now, but some Corpo does it and gets an article made about him

AND IVE LITERALLY SEEN ONE

It’s 90% accurate, 0.000000001% of the time.

Omg can anyone confirm that photo is real??

Great! I wonder how long this AI tech will last before it suspiciously stops working.

Source .. The Daily Star …

Lol what do you use for training data exactly?

90% might as well be 0% in my opinion, since it still won’t undeniably confirm nor deny any existence.